Ganzheitliche Reporting-Lösungen mit PowerBi und Microsoft Fabric

Wir hatten die Gelegenheit, mit Michael Wilhelm – Gründer von Datenhungrig und ausgewiesener Experte für ganzheitliche Reporting-Lösungen – über aktuelle Entwicklungen und Best Practices rund um Microsoft Power BI und Fabric zu sprechen.

Hallo Michael, du beschäftigst dich schon seit über 10 Jahren mit der Automatisierung von Reporting-Lösungen mit Schwerpunkt Power BI. Wie hat sich die Verwendung von Power BI in den Unternehmen entwickelt?

Erst einmal vielen Dank für die Einladung!

Ich denke Microsoft hat in den letzten Jahren mit Power BI den Business Intelligence Markt sehr stark verändert, indem es den Fachabteilungen eine Software in die Hand gegeben hat, welche es ermöglicht automatisierte Reporting-Lösungen zu entwickeln und bei dem Ausbau der Business Intelligence Landschaft deutlich stärker mitzuwirken.

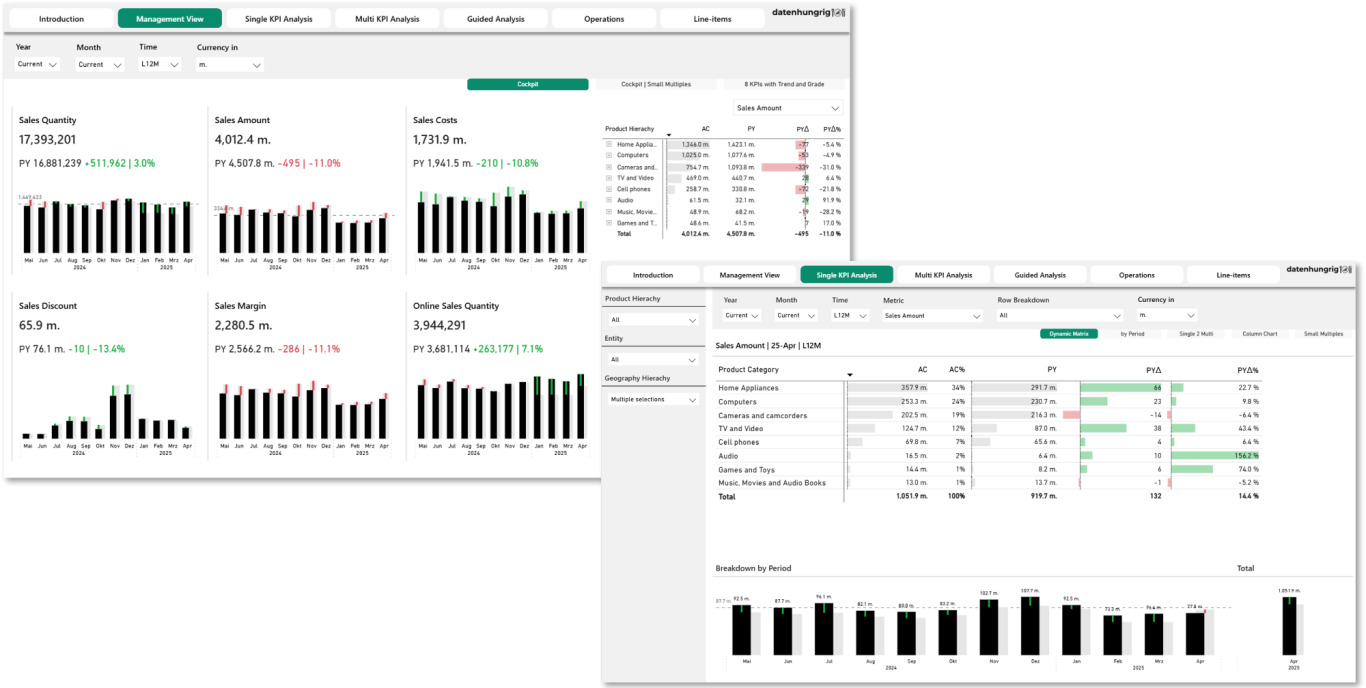

Mit Power BI lassen sich Daten aus verschiedenen Quellen effizient extrahieren, transformieren und in aussagekräftige Analysemodelle überführen, die anschließend interaktiv visualisiert und mit unterschiedlichen Zielgruppen geteilt werden können. Das Besondere dabei ist, dass Power BI die Ende-zu-Ende-Strecke von der Datenquelle bis zum Bericht in einer Lösung abdeckt und direkt in die Microsoft Office-Landschaft integriert ist.

Gerade für Unternehmen, die ihr Reporting zuvor sehr stark auf Excel aufgebaut haben und nun ihre Reise in eine professionellere Business Intelligence Landschaft mit höherem Automatisierungsgrad und umfangreicheren Analysemöglichkeiten gehen wollen, ist Power BI häufig der nächste logische Schritt. Denn aufgrund des umfangreichen Funktionsumfangs lassen sich effizient erste Anwendungsfälle entwickeln und in den Betrieb bringen.

Ein weiterer positiver Effekt ist, dass die Einführung von Power BI häufig das Verständnis der Mitarbeitenden für die Anforderungen, Methoden und Prozesse im Bereich Business Intelligence fördert. Besonders spürbar ist, dass in vielen Unternehmen das Bewusstsein für die Notwendigkeit automatisierter Reporting-Prozesse deutlich gestiegen ist. Die Etablierung von Standards und Best Practices wird zunehmend als Schlüssel gesehen, um Effizienz, Transparenz und Qualität im Reporting nachhaltig zu sichern.

Wie bewertest du Power BI im Kontext Self-Service?

Tatsächlich denkt man bei Power BI schnell an Self-Service und so wird es ja auch offen gesagt recht stark beworben. Dabei gibt es allerdings einige "Aber". Denn je mehr man sich mit Personen über das Thema Self-Service unterhält, desto mehr fällt auf, dass hier ein recht breit gestreutes Verständnis besteht und darüber hinaus die Erwartungshaltung recht weit von der Realität entfernt ist. Ich denke der Großteil ist sich einig, dass es bei Self-Service vor allem um die Fachbereiche geht, nämlich dass sie selbstständig und möglichst autark Daten analysieren können. Denn die Fachabteilungen wissen ja am besten was sie benötigen, sodass das Ping-Pong zwischen IT und Fachabteilung eingespart werden kann. Wo die Vorstellungen allerdings recht weit auseinandergehen, ist was genau der Fachbereich hier übernimmt und vor allem auch realistisch übernehmen kann. Ich spreche hier auch gerne von der Self-Service-Tiefe. Nehmen wir einmal die 3 folgenden Beispiele, was Self-Service bedeuten kann.

Self-Service Stufe 1: Fachanwender greifen auf zentral bereitgestellte interaktive Berichte zu, navigieren durch Seiten, filtern Daten und haben die Möglichkeiten, die verfügbaren Visualisierungen bis zu einem bestimmten Grad anzupassen. Für eigene Detailanalysen können die Daten des Reports exportiert und in Excel weiterverarbeitet werden. Hierfür sind lediglich grundlegende Kenntnisse für die Navigation in der Power BI Cloud erforderlich. Dazu gehört:

- Wo finde ich die Berichte, auf welche ich Zugriff habe?

- Wie navigiere ich durch einen Power BI Bericht?

- Was sind die typischen Features, die ich kennen sollte, um bestehende Power BI Berichte im vollen Umfang zu konsumieren?

Self-Service Stufe 2: Fachanwender erstellen auf Basis eines in der Power BI Cloud bereitgestellten Datenmodells eigene Power BI Berichte oder greifen sogar mit Excel direkt auf das Datenmodell zu, sodass Sie dieses vollumfänglich gemäß sehr individueller Anforderungen analysieren können. Dieser Ansatz erfordert bereits ein tiefgreifenderes Verständnis, zum Beispiel:

- Wie setzt sich das Datenmodell zusammen und was bedeutet welche Tabelle?

- Welche Berechnungslogiken stecken hinter den Metriken und wie verhalten sich diese in Kombination mit den verschiedenen Tabellen?

- Wie baue ich einen interaktiven Report, der intuitiv bedient werden kann wird?

Self-Service Stufe 3: Fachanwender entwickeln komplett eigenständig ganze Datenmodelle, indem sie sich direkt mit den Quellsystemen verbinden, die Daten aufbereiten, Berechnungslogiken ergänzen, die Daten in interaktiven Berichten visualisieren und vollumfänglich die Zugriffsrechte verwalten. In diesem Szenario übernimmt die Fachabteilung den kompletten Aufbau der Power BI Lösung, weswegen neben den bereits genannten Punkten, unter anderem ergänzend die folgenden Wissensbausteine vorhanden sein sollten:

- Was sind gute Praktiken der Datenintegration und Datenmodellierung und wie realisiere ich diese in Power BI?

- Wie entwickle ich mit den Power BI Sprachen "M" und "DAX" effektive Modelle, die vielfältig verwendet werden können und konsistente Ergebnisse liefern?

- Wie stelle ich sicher, dass die Lösung auch bei neuen Anforderungen noch gut erweitert werden kann, langfristig nachvollziehbar bleibt und dementsprechend gut gewartet werden kann?

- Wie setze ich ein schlankes, sicheres, aber dennoch flexibles Berechtigungsmanagement auf?

Nach meiner Einschätzung wird in öffentlichen Medien häufig der Eindruck erweckt, dass der Großteil im Self-Service gemäß Stufe 3 alle möglichen Daten anzapft und ihre Lösungen baut. Die Realität sieht jedoch anders aus. Häufig verfügen nur wenige über das notwendige Know-how und vor allem die Zeit, Datenmodelle und Berichte vollständig eigenständig zu entwickeln. Es ist ja auch recht ineffizient und fehleranfällig, wenn alle parallel die gleichen Lösungen bauen. Meist stellen wenige Experten Lösungen bereit, die von einer großen Zahl an Mitarbeitenden auf Stufe 1 und einer ausgewählten Zahl an Mitarbeitenden in Stufe 2 genutzt werden.

Hier unterscheidet sich der BI-Prozess nicht von anderen Unternehmensprozessen, wie zum Beispiel HR-Prozesse. Es ist sinnvoll, Fachabteilungen in HR-Prozesse einzubinden, aber ineffizient, wenn jede Abteilung den gesamten HR-Prozess selbst definiert und organisiert. Genauso sollte es beim Self-Service BI eine realistische Aufwand-Nutzen-Abwägung erfolgen.

Ich bin davon überzeugt, dass egal ob Self-Service oder nicht, jede BI-Landschaft eine Instanz benötigt, die zentral für das Thema verantwortlich ist, Expertise in diesem Gebiet vorweist und das Thema koordiniert. Von hier aus gilt es dann zu definieren, was von der Instanz selbst zentral übernommen wird und welche Tätigkeiten von Fachabteilungen teilweise oder komplett übernommen werden. Dabei kann es von Abteilung zu Abteilung unterschiedlich gehändelt werden. Sobald allerdings eine Fachabteilung Aufgaben gemäß Self-Service übernimmt, sollte es auch hier ausgewählte Verantwortliche geben, die das Thema für Ihre Fachabteilung aufsetzen und koordinieren.

Siehst du bei der Verwendung von Power BI noch weitere Herausforderungen?

Power BI deckt grundsätzlich die gesamte Kette von der Datenquelle bis zur Visualisierung ab und ist in vielen Szenarien sehr leistungsfähig. Doch insbesondere bei der Transformation der Daten, also dem Teil, wo die aus den Quellsystemen extrahierten Daten bereinigt, harmonisiert und miteinander verknüpft werden, gibt es bei Power BI Grenzen.

Bei klassischen Datentransformationsaufgaben mit Datensätzen von mehreren Millionen Zeilen liefert Power BI mit seiner Power Query Engine ein solides Portfolio an Features. Doch insbesondere mit wachsender Anzahl an Datenquellen und zunehmend komplexen Transformationsanforderungen, ist die Einbindung weiterer Technologien empfehlenswert.

Zum einen liegt das daran, dass Power BI bei jeder Aktualisierung alle Daten erneut lädt und auf den Daten nachgelagert keine Änderungen vorgenommen werden können. Diese Eigenschaft bringt vor allem Limitierungen bei inkrementellen Ladevorgängen sowie in der Historisierung von Daten, wenn ich also historisch Daten behalten und nicht mit einer neuen Aktualisierung überschreiben möchte. Darüber hinaus lassen sich die Daten aus den analytischen Modellen nur mit Limitierungen für andere Datenmodelle wiederverwenden.

Je mehr Datenmodelle nun entwickelt werden und je mehr Überschneidungen es bei den Daten der Modelle gibt, desto mehr redundante Datentransformation entsteht. Wenn nun auch verschiedene Personen diese Datenmodelle bereitstellen, steigt umso mehr das Risiko, dass die gleichen Daten in verschiedenen Modellen nach verschiedenen Definitionen und Regeln transformiert werden, was wiederum zu vermehrten Inkonsistenzen zwischen den verschiedenen Datenmodellen führt.

Zwar bietet Power BI Optionen für die Zentralisierung der Datenaufbereitung, diese sind allerdings häufig nicht ausreichend. Daher ist für solche Herausforderungen die Einbindung einer zentralen Datenplattform – etwa in Form eines Data Warehouses oder Lakehouses in Verbindung mit spezialisierten Transformationslösungen – das Mittel der Wahl. Hier können mit einem deutlich umfangreicheren Portfolio an Funktionalitäten Daten voraufbereitet und für eine Vielzahl an BI-Entwicklern, welche z.B. mit Power BI arbeiten, zur Verfügung gestellt werden. Das Ziel besteht also darin, wesentliche Transformationsschritte zu zentralisieren, damit nachgelagerte Lösungen auf einer konsistenten Basis aufsetzen. Microsoft ist sich schon sehr lange dieser Herausforderung bewusst und hat daher im Jahr 2023 Microsoft Fabric veröffentlicht.

Klingt spannend! Was steckt hinter Microsoft Fabric?

Microsoft Fabric ist ein zusätzlicher Microsoft-Service, der die Power BI-Umgebung um etablierte Technologien aus den Bereichen Data Warehousing, Data Science und Realtime-Analytics erweitert.

Mit Power BI lassen sich grundsätzlich Ende-zu-Ende-BI-Lösungen realisieren, was vor allem zu Beginn einer Business Intelligence Initiative gut funktioniert. Mit zunehmender Skalierung – mehr Quellsysteme, Daten, BI-Entwickler, Reporting-Konsumenten und steigende Anforderungen an die Datenqualität – wird jedoch die zentrale Datenvorbereitung zum erfolgskritischen Faktor.

In solchen Fällen empfiehlt sich der Einsatz spezialisierter ETL-Tools oder zentraler Datenplattformen, um eine nachhaltige Datenqualität und Wiederverwendbarkeit sicherzustellen. Hier setzt Microsoft Fabric an: Es stellt ein spezialisiertes Technologie-Portfolio bereit, das Data Engineering und Data Science direkt in die Power BI-Umgebung integriert und flexibel skaliert werden kann.

Wie schätzt du die Integration von Power BI und Fabric ein? Welche Chancen und Herausforderungen entstehen dabei für Unternehmen?

Die Integration von Fabric in die Power BI Landschaft ist nach meiner Einschätzung sehr gut gelungen. Besonders für Organisationen, die bereits Power BI etabliert haben, ihre Umgebung nahtlos um fortschrittliche Technologien erweitern und sich möglichst wenig mit der Wartung der Infrastruktur beschäftigen möchten, ist Fabric eine sehr attraktive Option.

Nach der Aktivierung von Fabric stehen direkt die weiteren Technologien innerhalb der Power BI Cloud zur Verfügung und es kann unmittelbar mit dem Ausbau der BI-Landschaft begonnen werden, ohne dass eine separate Infrastruktur aufgebaut werden muss. Ob Lakehouses in Verbindung mit Notebooks, Python und PySpark oder klassische SQL-basierte Data Warehouses – diese und weitere Artefakte lassen sich mit wenigen Klicks in die BI-Landschaft integrieren.

Natürlich gibt es auch Herausforderungen. Nehmen wir als Beispiel eine Organisation, die bisher ausschließlich mit Power BI arbeitet und nun Fabric integrieren möchte. Beispielhafte Herausforderungen wären hier unter anderem:

Kostenmodell: Während sich die Kosten bei Power BI Pro oder Power BI Premium pro Nutzer sehr vorausschauend berechnen lassen, hängen sie bei Fabric von der gewählten Kapazitätsgröße ab, welche sich wiederum von der benötigten Rechenleistung abhängt. Eine Unterdeckung der Kapazitäten führt zum Beispiel zu schlechter Performance oder zu Abbrüchen von Jobs. Eine Überdimensionierung führt zu unnötigen Kosten.

Weiterbildung: Fabric integriert zahlreiche neue Komponenten in Verbindung mit anderen Programmiersprachen, die über die klassischen Power BI-Funktionen hinausgehen. Mitarbeitende müssen sich daher mit neuen Konzepten, Workflows und Tools vertraut machen, was gezielte Weiterbildung oder das Einkaufen zusätzlicher Expertise erfordert.

Durch das veränderte Preismodell und die Vielzahl an neuen Komponenten ist es noch wichtiger, eine effektive und nachvollziehbare Architektur auf Basis guter Praktiken zu etablieren. Schlecht geplante Architekturen können schnell zur Kostenfalle, da unnötig hohe Kapazitäten benötigt werden. Für Unternehmen, die das Risiko eines Vendor-Lock-ins eingrenzen wollen, ist das Thema Architektur ebenfalls besonders wichtig, da die Auswahl und Zusammenstellung der Fabric-Komponenten hier eine signifikante Rolle spielt.

Abschließend lässt sich sagen, dass die Integration von Fabric in Power BI Unternehmen eine Vielzahl neuer Möglichkeiten eröffnet, vor allem wenn man bisher mit Power BI arbeitet und die zentrale Datenaufbereitung auf ein neues Level heben möchte. Gleichzeitig erfordert der erfolgreiche Einsatz eine bewusste Auseinandersetzung mit neuen Technologien, ein angepasstes Kostenmanagement inkl. Monitoring, vorausschauende Architekturgestaltung und gezielte Weiterbildung der Mitarbeitenden. Wer diese Herausforderungen proaktiv adressiert, kann von einer modernen, leistungsfähigen BI-Plattform profitieren.

Vielen Dank für die spannenden Einblicke, Michael. Eine letzte Frage: Worauf sollten Unternehmen besonders achten, um ihre BI-Landschaft zukunftssicher und erfolgreich zu gestalten?

Es gibt hier leider nicht das eine Geheimrezept und die Frage ist sehr vielschichtig zu betrachten. Nichtsdestotrotz möchte ich gerne ein paar Punkte mitgeben, welche nach meiner Erfahrung eine große Auswirkung auf den langfristigen Erfolg haben.

- Verantwortlichkeiten: Ernenne eine Person oder einen Bereich, welcher die BI-Landschaft des Unternehmens aktiv plant und zentral koordiniert. Von hier aus wird abgestimmt, welche Themen zentral bewerkstelligt werden und wo die Übergabepunkte zu den Fachbereichen liegen. Dabei kann es häufig zu unterschiedlichen Vorgehensweisen zwischen den Fachabteilungen kommen. Sofern ein Fachbereich Aufgaben übernimmt, ernenne auch hier Verantwortliche, welche die Themen in ihren Fachbereichen verantwortet.

- Iteratives Vorgehen: Entwickle die BI-Landschaft in iterativen Schritten, also eher mit kleineren Projekten und zügigen Ergebnissen, die direkten Mehrwert für eine bestimmte Zielgruppe erzeugen. Denn genau diese Erfolgsgeschichten schaffen das Awareness und können als Beispiel in weitere Fachbereiche getragen, um dort die nächsten Anwendungsfälle zu identifizieren. Vermeide im Gegenzug also wenig spezifizierte Großprojekte mit langer Laufzeit, insbesondere wenn deren Nutzen nicht klar oder zu vage beschrieben ist.

- Technologie: Wähle Technologien bedarfsgerecht und zukunftsorientiert. Statt direkt auf eine umfassende High-End-Datenplattform zu setzen, sollte die technologische Ausstattung schrittweise und entlang der tatsächlichen Anforderungen erfolgen. Achte jedoch darauf, einzelne Technologien nicht zu lange über ihre Grenzen hinaus zu nutzen – dies führt langfristig zu erhöhtem Wartungsaufwand, Performance-Einbußen und Qualitätsproblemen. Setze daher frühzeitig auf skalierbare und flexible Lösungen, die mit den Anforderungen wachsen können.

- Expertise: Sorge dafür, dass deine Organisation kontinuierlich und gezielt Expertise aufbaut und gemäß guter Praktiken arbeitet. Gerade wenn Software im Spiel ist, können wenige Personen mit Expertenwissen Landschaften entwickelt und betreuen, welche eine viel größere Zahl an Mitarbeitenden einen signifikanten Mehrwert liefert. Sollte es in Bereichen an Wissen oder Erfahrung mangeln, setze auf punktuell begleitende Beratung durch Spezialisten anstatt auf generische Einzeltrainings.

- Daten: Erkenne an, dass die Datenqualität der Berichte und Reports aus den Quellsystemen bestimmt wird. Unabhängig von der BI-Landschaft sollte z.B. bereits in den Quellsystemen verankert werden, welche Stammdaten besonders wichtig sind, welchen System für die jeweiligen Daten führend ist und auf welche Art und Weise die Daten standardisiert gepflegt werden.

Wie bereits beschrieben, sind die Schwerpunkte von Unternehmen zu Unternehmen verschieden. Ich denke jedoch, dass diese Richtlinien einen Großteil der Unternehmen auf die Richtige Spur bringen, wobei hinter diesen schnell gesagten Punkte auch jede Menge Arbeit und Herausforderungen stecken.

Zu Michael Wilhelm

Michael ist Berater und Entwickler mit Schwerpunkt Microsoft Power BI und Fabric. Er unterstützt seit mehr als 10 Jahren mittelständische und große Unternehmen bei dem Aufbau automatisierter Reporting-Lösungen. Dabei vereint er tiefgründige Expertise in der Datenintegration, -modellierung und -visualisierung mit umfassenden Fach- und Prozessverständnis.

Seine Beratung beinhaltet sowohl die Entwicklung und Optimierung ganzheitlicher Reporting-Lösungen als auch die individuelle Beratung einzelner Mitarbeiterinnen und Mitarbeiter im Rahmen flexibel buchbarer On-Demand Consulting-Sessions.

Michael legt großen Wert darauf, dass seine Lösungen anwenderfreundlich, nachvollziehbar und wartungsarm sind. Dafür investiert er viel Zeit in die kontinuierliche Verprobung von Features und die Entwicklung neuer Ansätze, wodurch er seine Kunden mit einem Werkzeugkoffer etablierter Methoden und Standards zielgerichtet berät. Auf LinkedIn teilt er regelmäßig Beispiele und Impulse rund um Microsoft Power BI und Fabric.